秋风下的落叶 发表于 2019-12-16 08:46

nfs是什么意思?

zxxx 发表于 2019-12-16 08:56

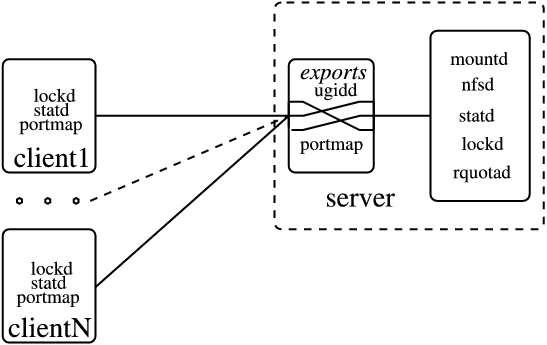

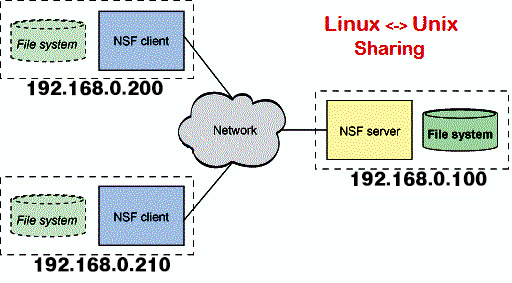

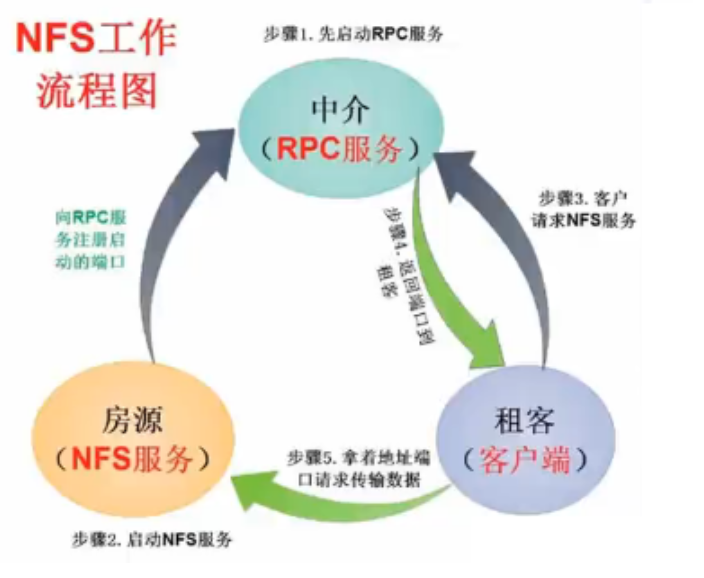

NFS 网络文件系统是一种分布式文件系统协议,力求客户端主机可以访问服务器端文件,并且其过程与访问本地 ...

秋风下的落叶 发表于 2019-12-16 09:03

大复杂,没看懂啥意思

凤梨 发表于 2019-12-16 09:15

相当于30刀买了个5T流量的大盘鸡

smalleye 发表于 2019-12-16 11:15

大佬,伦敦250G单出吗

zxxx 发表于 2019-12-16 09:34

云筏科技有个30刀的机器,1T硬盘,5T流量更香。

smalleye 发表于 2019-12-16 11:15

大佬,伦敦250G单出吗

要是前端机子配置高就香喷喷了。

要是前端机子配置高就香喷喷了。exexue 发表于 2020-1-5 16:51

root@ultravps-de:/data# time dd if=/dev/zero of=/data/128MB.bin bs=128k count=1024

1024+0 records in ...

kxzd 发表于 2020-1-7 09:39

30刀1t流量你逗我呢,还不如搞个大盘鸡

zxxx 发表于 2020-1-10 20:08

30 刀是 1T + 5T, 合计 6T 的

kxzd 发表于 2020-1-10 23:38

我这拉斯维加斯貌似无限流量的

zxxx 发表于 2020-1-10 23:47

无限流量的好呀!

| 欢迎光临 全球主机交流论坛 (https://hostloc-workers.ikyomon.com/) | Powered by Discuz! X3.4 |